Explore

Make

Reveal

Conseil en réalité augmentée, réalité virtuelle et intelligence artificielle

Clarté, accélérateur d’innovations immersives

Depuis plus de 25 ans nous sommes l’acteur de référence dans le domaine de la réalité virtuelle et augmentée pour les usages professionnels. Nous sommes à la fois explorateurs, créateurs et passeurs. Nous aidons nos clients à accroître leur performance au travers de missions de conseil et de développement de solutions en lien avec les technologies immersives et d’assistance cognitive.

Ils nous font confiance

Des services pour les professionnels

Nous vous accompagnons dans l'intégration de la VR/AR dans votre entreprise

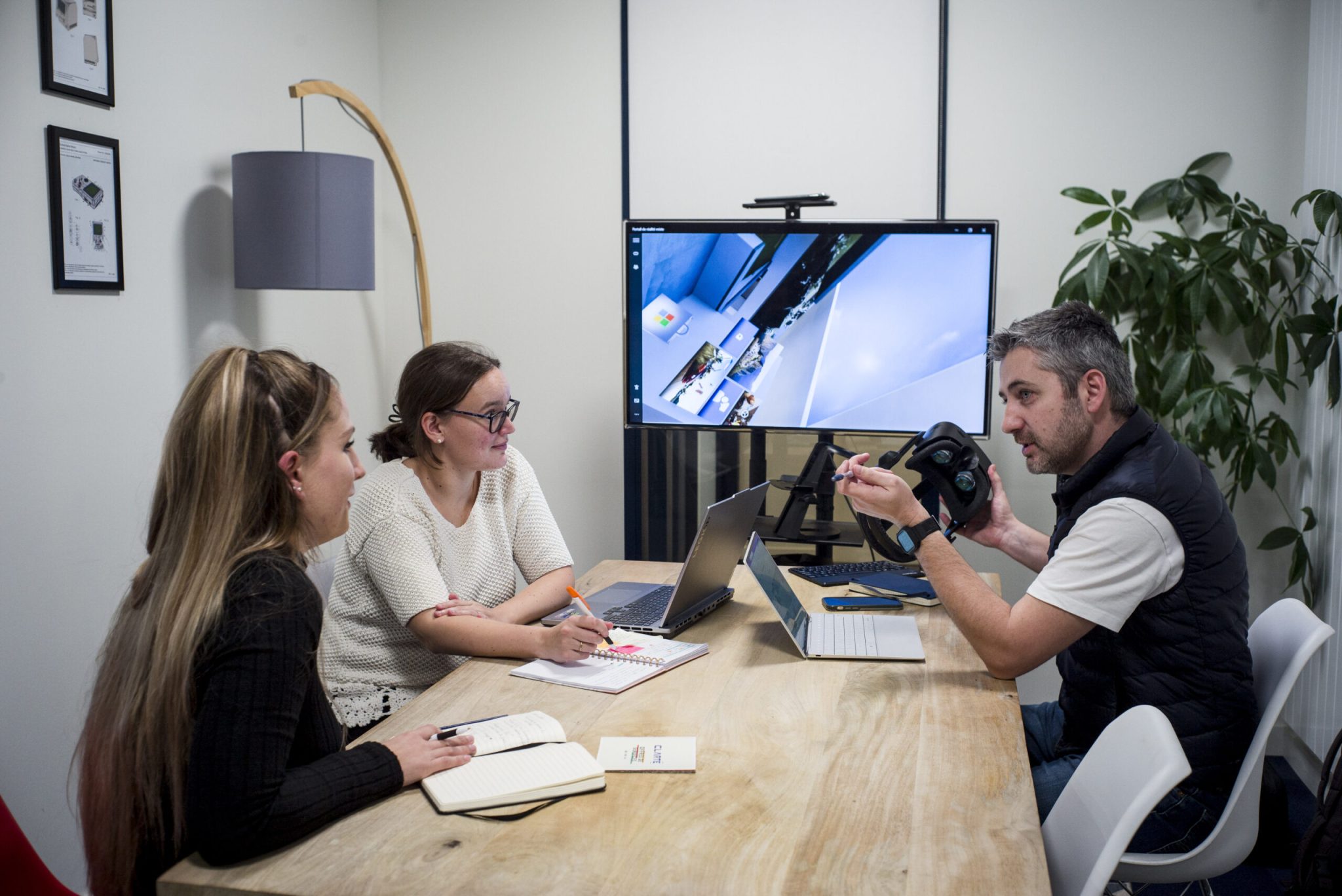

Vous avez une idée de projet ou des besoins spécifiques au sein de votre entreprise ? Nous sommes là pour vous guider et élaborer la solution optimale en accord avec vos objectifs. Que ce soit la rédaction d’un cahier des charges, la réalisation d’études comparatives de solutions ou encore le développement de A à Z de votre projet : nos experts prendront en charge ces missions pour vous offrir un accompagnement sur mesure.

On réalise vos projets VR/AR

Nous sommes les pionniers du développement en réalité virtuelle, augmentée et intelligence artificielle. Avec notre équipe d’ingénieurs et docteurs spécialisés, nous concevons des solutions avant-gardistes pour repousser les limites technologiques et répondre aux besoins de nos clients. Notre approche axée sur l’innovation nous permet de créer des expériences uniques. Une fois la solution développée, nous assurons un transfert de technologie.

Gratuit

Découvrez les technologies immersives

Bénéficiez d’un échange gratuit et personnalisé avec l’un de nos conseillers technologiques pour découvrir le potentiel de la réalité virtuelle, augmentée et mixte. Lors d’un rendez-vous dans vos locaux, à distance, au SPi du numérique à Saint-Nazaire ou au Laval Virtual Center, un conseiller vous présente les dernières technologies et leurs usages, tout en discutant de vos besoins et des solutions possibles applicables à votre secteur.

Gratuit

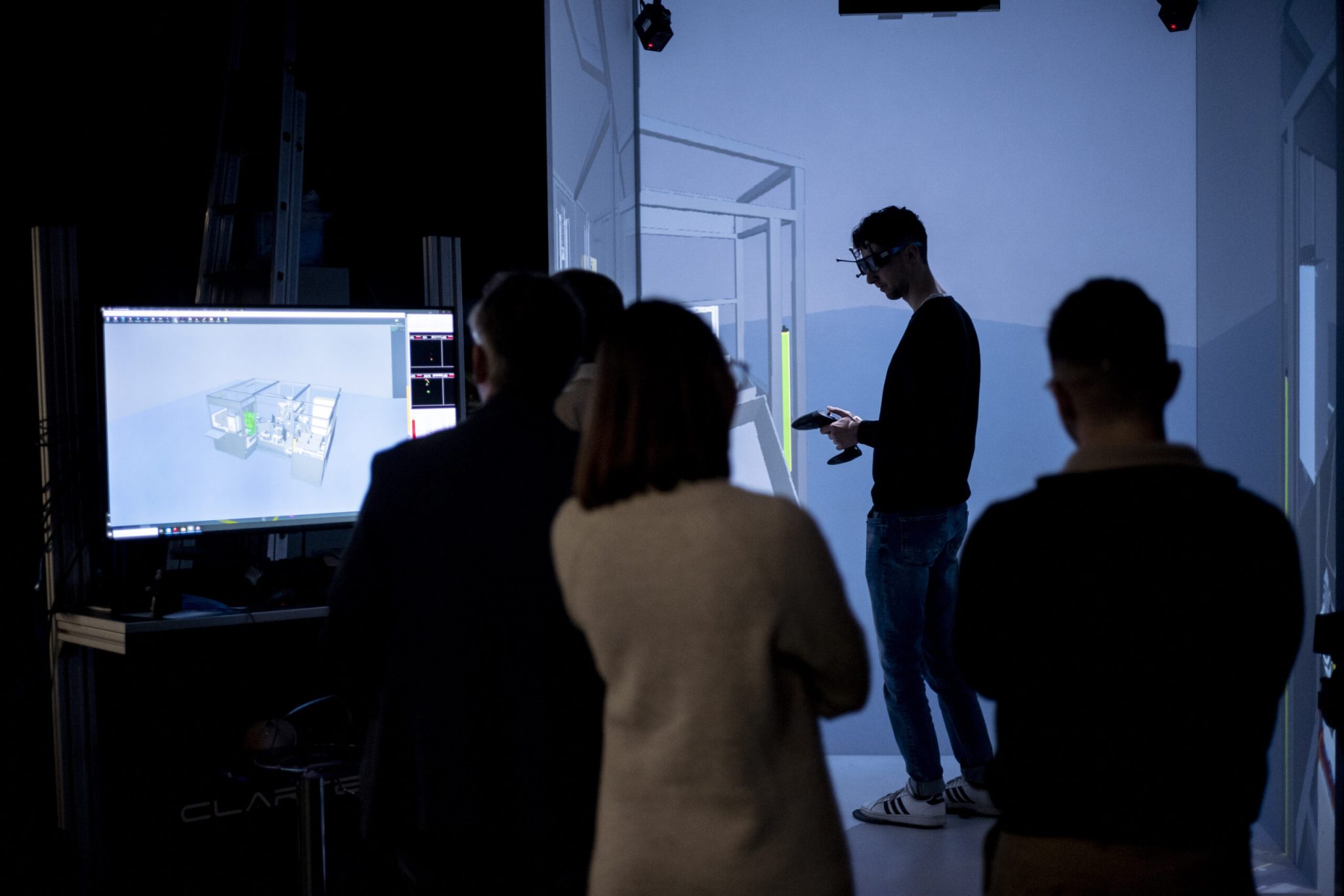

Découvrez et testez avec vos équipes

Dans notre showroom de démonstrations (Holodeck), venez tester les technologies de réalité augmentée et virtuelle. Découvrez des cas d’usages concrets et les bénéfices dans votre secteur d’activité grâce à plus de 25 démonstrations disponibles. Nous disposons des derniers équipements du marché.

Utilisez la VR/AR dans votre entreprise

Découvrez les avantages de la VR/AR avec notre service de location de valises adaptées aux PME. Livraison rapide à vos bureaux, formation personnalisée et test sur 1 mois pour des bénéfices immédiats. Explorez 4 usages en PME : revue de conception, visualisation, assistance au poste de travail et expertise à distance.

Formez-vous à la RV/RA

Plongez dans l’univers passionnant des outils de création et de développement d’applications personnalisées de réalité virtuelle et augmentée. Nos formations sont adaptées aux entrepreneurs, développeurs web et infographistes. Des sessions de 2 à 4 jours offrent un équilibre entre théorie et pratique, avec accès à des équipements adaptés. Notre organisme est certifié Qualiopi.

VR

Réalité virtuelle

Créer une grande variété d’environnements

La réalité virtuelle est une technologie qui plonge les utilisateurs dans des environnements numériques interactifs (3D), recréant des scénarios et des situations de manière immersive. Dans l’industrie, la VR est utilisée pour créer des simulations et des environnements de formation virtuels, pour la conception de produits, la visualisation de données complexes et bien plus encore.

AR

Réalité augmentée / mixte

Résoudre les problèmes en temps réel

La réalité augmentée ou mixte permet d’intégrer des éléments numériques dans le monde réel. Les entreprises peuvent ainsi créer des applications pour permettre aux clients de visualiser des produits en 3D dans leur environnement avant l’achat, améliorer la formation en superposant des instructions virtuelles à l’équipement réel, aider les techniciens à effectuer des réparations, etc. Les exemples sont nombreux.

AI

Intelligence artificielle

Aider l’humain dans son quotidien

L’intelligence artificielle est un domaine technologique très large. Chez Clarté, nous nous intéressons à développer des usages qui permettent aux IA de comprendre visuellement l’environnement autour de l’opérateur et de converser avec lui afin « d’augmenter » ses capacités cognitives. Ces IA peuvent également concrétiser de nouvelles formes d’interactions avec les machines et détecter des risques en situation de travail.

Les bénéfices des technologies immersives

Bénéficiez d’un accompagnement adapté à vos besoins

Quelle que soit la taille de votre entreprise, sécurisez votre projet innovant avec un accompagnement personnalisé. De la découverte à la mise en œuvre, nos conseillers technologiques sont là pour vous guider à chaque étape de votre projet. Profitez d’une expertise reconnue et sur mesure pour assurer le succès de votre entreprise.